Jak powstała sztuczna inteligencja? Od starożytnych wizji po rewolucję deep learningu

- Idea sztucznej inteligencji sięga starożytnych mitów i filozoficznych rozważań o logice, zanim jeszcze pojawiły się komputery.

- Oficjalny początek AI jako dziedziny naukowej datuje się na konferencję w Dartmouth w 1956 roku, z Alanem Turingiem i jego testem jako kluczowymi prekursorami.

- Wczesne sukcesy (Perceptron, ELIZA) doprowadziły do nadmiernego optymizmu, a następnie do tzw. "zim AI" w latach 70. i 80., kiedy to rozwijały się systemy ekspertowe.

- Przełomowe momenty to zwycięstwa Deep Blue nad Kasparowem (1997) i AlphaGo nad Lee Sedolem (2016), pokazujące zdolność maszyn do pokonywania ludzi w złożonych grach.

- Rewolucja głębokiego uczenia, zapoczątkowana przez pionierów takich jak Hinton, LeCun i Bengio oraz przełom ImageNet w 2012 roku, doprowadziła do obecnego dynamicznego rozwoju AI.

- Współczesna AI, od generatywnych modeli językowych po wizję komputerową, jest integralną częścią naszego życia, a Polska aktywnie uczestniczy w jej rozwoju.

Od starożytnych marzeń po filozoficzne fundamenty: początki myśli o sztucznej inteligencji

Zanim jeszcze pojawiły się komputery, a nawet samo pojęcie "sztucznej inteligencji", ludzkość od wieków fascynowała się ideą tworzenia bytów na swoje podobieństwo istot zdolnych do myślenia, działania i naśladowania ludzkich zdolności. Już w starożytnych mitach odnajdujemy echa tych pragnień: od żydowskiego Golema, przez greckiego Talosa, giganta z brązu, po mechaniczne automaty, które miały służyć bogom lub władcom. Te opowieści pokazują, że marzenie o inteligentnych maszynach jest głęboko zakorzenione w naszej kulturze i wyobraźni.

Filozoficzne podstawy, które ostatecznie umożliwiły rozwój AI, zaczęły kształtować się znacznie później. To myśliciele tacy jak Gottfried Wilhelm Leibniz, który w XVII wieku marzył o "kalkulatorze logicznym" zdolnym do rozwiązywania sporów za pomocą obliczeń, oraz George Boole, twórca algebry Boole’a w XIX wieku, położyli fundamenty pod logikę komputerową. Ich prace nad formalizacją myślenia i wnioskowania stały się absolutnie kluczowe dla algorytmów i systemów, które dziś stanowią kręgosłup sztucznej inteligencji. Bez nich nie byłoby mowy o programowalnych maszynach.

Narodziny legendy: przełomowe momenty, które ukształtowały sztuczną inteligencję

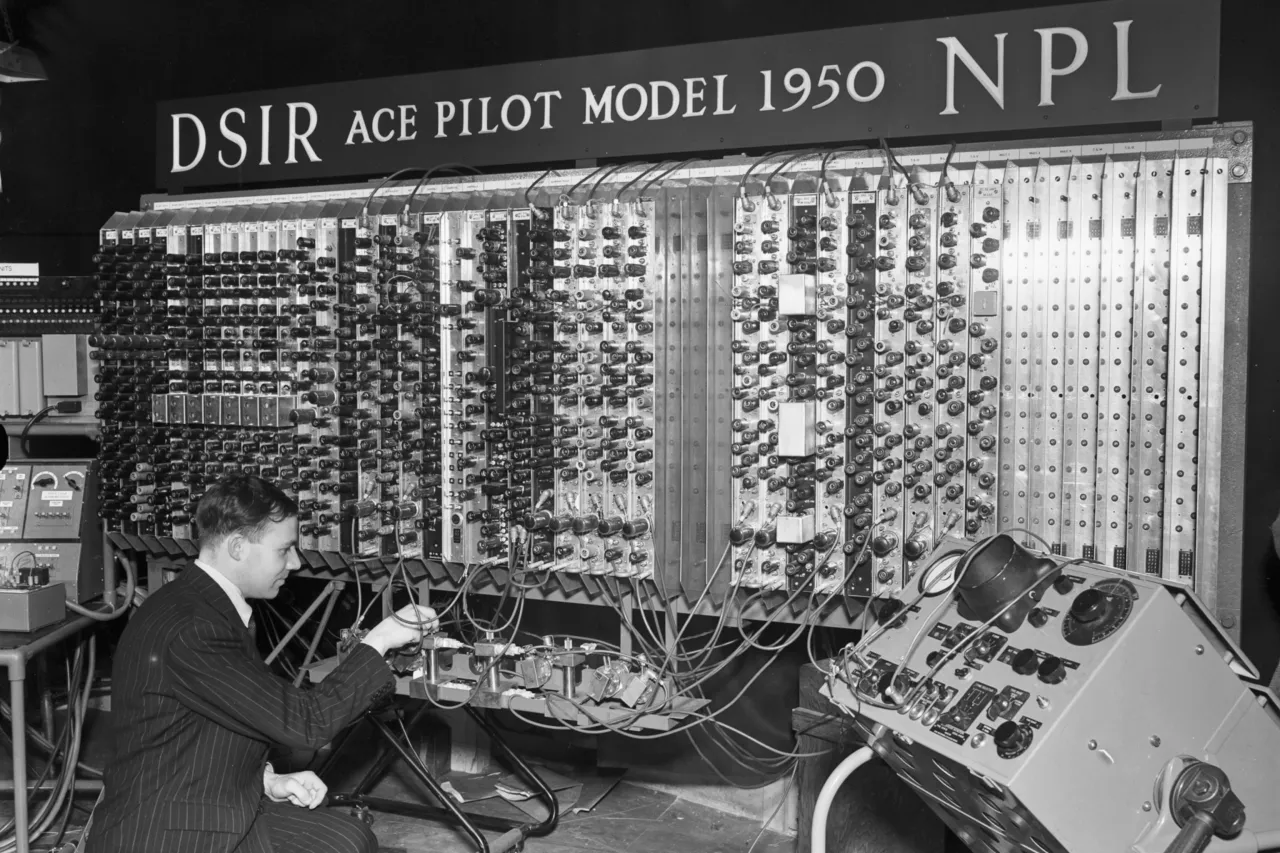

Prawdziwy przełom w myśleniu o maszynach zdolnych do inteligencji nastąpił w połowie XX wieku, a jego centralną postacią był Alan Turing. Ten wybitny brytyjski matematyk w swojej przełomowej pracy "Computing Machinery and Intelligence" z 1950 roku zadał fundamentalne pytanie: "Czy maszyny mogą myśleć?". Zaproponował również koncepcję, którą dziś znamy jako "Test Turinga" metodę oceny, czy maszyna jest w stanie wykazywać inteligentne zachowanie nierozróżnialne od ludzkiego. To było jak zapalenie iskry, która rozświetliła drogę dla całej nowej dziedziny nauki.

Oficjalny początek AI jako odrębnej dziedziny naukowej datuje się na słynną Konferencję w Dartmouth w 1956 roku. To właśnie tam, dzięki inicjatywie Johna McCarthy'ego, który również jest twórcą samego terminu "sztuczna inteligencja" (ang. "artificial intelligence"), zebrali się pionierzy tacy jak Marvin Minsky, Nathaniel Rochester i Claude Shannon. Ich celem było zbadanie, jak sprawić, by maszyny rozwiązywały problemy, które obecnie zarezerwowane są dla ludzi. Ta konferencja nie tylko nadała nazwę nowej dziedzinie, ale też wyznaczyła kierunki badań na dekady.

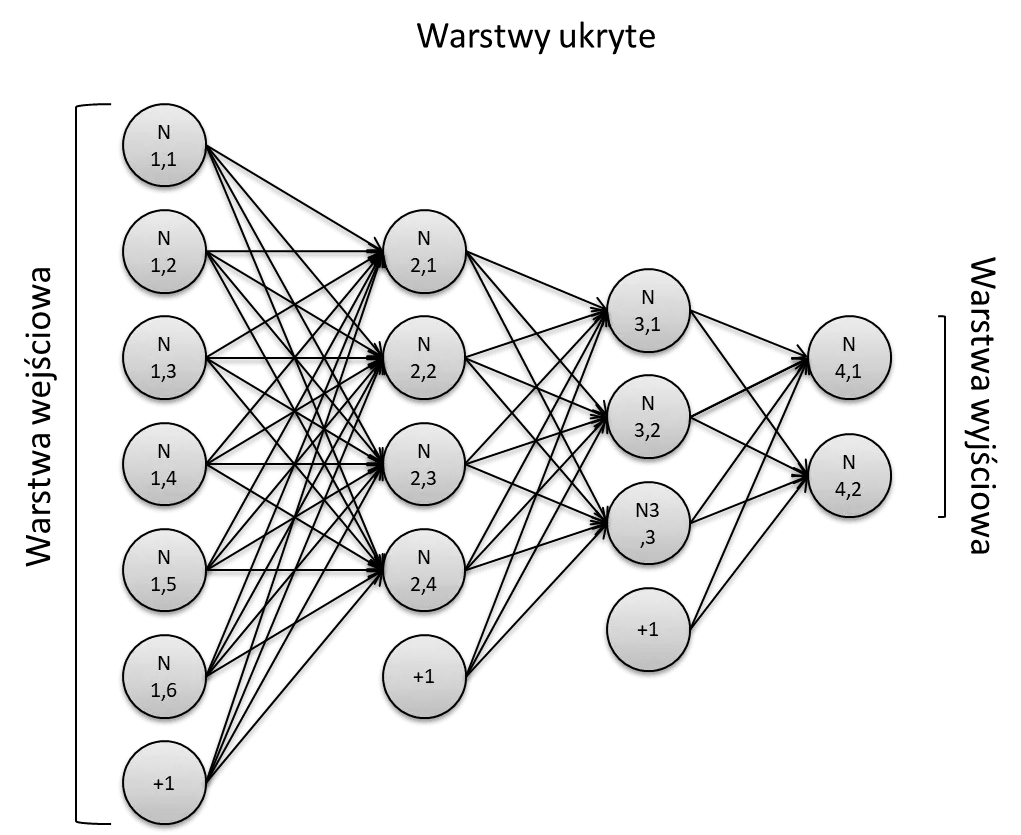

Kolejnym kamieniem milowym było stworzenie Perceptronu przez Franka Rosenblatta w 1958 roku. Perceptron był jedną z pierwszych sztucznych sieci neuronowych, inspirowaną budową ludzkiego mózgu. Potrafił uczyć się rozpoznawania wzorców, na przykład odróżniania obrazków. Chociaż był to prosty model, jego zdolność do uczenia się poprzez doświadczenie była absolutnie rewolucyjna i położyła podwaliny pod rozwój uczenia maszynowego, które dziś napędza większość systemów AI.

Od euforii do rozczarowania: pierwsza "zima AI" i jej kluczowe lekcje

Wczesne sukcesy i optymizm wokół AI doprowadziły do obietnic, które okazały się trudne do spełnienia. W latach 70. i 80. XX wieku nastąpił okres, który historycy AI nazywają "pierwszą zimą AI". Początkowy entuzjazm opadł, ponieważ badacze napotkali na ogromne ograniczenia technologiczne i obliczeniowe. Maszyny nie były wystarczająco potężne, a algorytmy zbyt prymitywne, by sprostać złożoności świata rzeczywistego. Finansowanie badań zmalało, a wielu naukowców zniechęciło się, co pokazało, że droga do prawdziwej inteligencji maszynowej będzie znacznie dłuższa i bardziej wyboista, niż początkowo sądzono.

Mimo "zimy AI", badania nie ustały całkowicie. W tym okresie rozwijały się systemy ekspertowe, które stały się jednym z najbardziej praktycznych i obiecujących kierunków. Były to programy komputerowe, które naśladowały proces decyzyjny ludzkiego eksperta w konkretnej dziedzinie. Działały na zasadzie bazy wiedzy (zbioru reguł i faktów) oraz silnika wnioskującego, który na podstawie tych reguł wyciągał wnioski. Chociaż ich zastosowanie było ograniczone do wąskich dziedzin, takich jak diagnostyka medyczna czy konfiguracja komputerów, pokazały one realną wartość AI w rozwiązywaniu konkretnych, złożonych problemów, co pomogło utrzymać zainteresowanie dziedziną.

Moment, w którym maszyna prześcignęła mistrza: historyczne zwycięstwa AI

Po okresie stagnacji, świat AI doczekał się spektakularnych sukcesów, które na nowo rozpaliły wyobraźnię i pokazały ogromny potencjał maszyn. Jednym z najbardziej pamiętnych wydarzeń był historyczny pojedynek komputera Deep Blue firmy IBM z mistrzem świata w szachach Garrym Kasparowem w 1997 roku. Zwycięstwo Deep Blue nad arcymistrzem było symbolicznym momentem, w którym maszyna pokonała człowieka w domenie uważanej za szczyt ludzkiego intelektu i strategicznego myślenia. To nie było tylko zwycięstwo technologii, ale sygnał, że AI wkracza w nową erę, w której jej możliwości zaczynają dorównywać, a nawet przewyższać ludzkie w specyficznych zadaniach.

Kolejnym, jeszcze bardziej znaczącym przełomem, był pojedynek programu AlphaGo firmy DeepMind (należącej do Google) z mistrzem świata w Go, Lee Sedolem, w 2016 roku. Gra Go jest znacznie bardziej złożona niż szachy liczba możliwych ruchów jest astronomicznie większa, co sprawia, że poleganie wyłącznie na brute-force (przeszukiwaniu wszystkich możliwych ruchów) jest niemożliwe. Zwycięstwo AlphaGo, które wykorzystywało zaawansowane techniki głębokiego uczenia i uczenia ze wzmocnieniem, pokazało, że AI jest w stanie opanować intuicję i kreatywność, cechy dotychczas uważane za wyłącznie ludzkie. To wydarzenie na dobre zapoczątkowało obecną rewolucję w AI.

Rewolucja głębokiego uczenia: jak sieci neuronowe odmieniły świat AI

Obecny dynamiczny rozwój AI, który obserwujemy, jest w dużej mierze zasługą rewolucji głębokiego uczenia (deep learning). Za jej "ojców chrzestnych" uważa się trzech wybitnych naukowców: Geoffreya Hintona, Yanna LeCuna i Yoshuę Bengio. Ich prace nad sieciami neuronowymi, zwłaszcza nad algorytmem wstecznej propagacji błędu (backpropagation) w latach 80. i 90. XX wieku, były fundamentalne. To oni niestrudzenie rozwijali koncepcje, które przez długi czas były niedoceniane, wierząc w potencjał wielowarstwowych sieci neuronowych. W 2018 roku za swoje dokonania otrzymali Nagrodę Turinga, co jest najwyższym wyróżnieniem w informatyce.

Prawdziwy przełom i moment, w którym deep learning zyskał globalne uznanie, nastąpił w 2012 roku, gdy sieć neuronowa AlexNet wygrała konkurs ImageNet. AlexNet, zaprojektowana przez Alexa Krizhevsky'ego, Ilię Sutskevera i Geoffreya Hintona, znacząco przewyższyła wszystkie inne metody w zadaniu rozpoznawania obrazów, drastycznie zmniejszając wskaźnik błędów. To wydarzenie zapoczątkowało prawdziwą rewolucję w dziedzinie głębokiego uczenia i wizji komputerowej, otwierając drogę do niezliczonych nowych zastosowań, od autonomicznych samochodów po zaawansowaną diagnostykę medyczną.

W ostatnich latach obserwujemy gwałtowny rozwój i popularyzację generatywnej AI. Duże modele językowe (LLM), takie jak seria GPT od OpenAI, oraz modele do generowania obrazów, takie jak Midjourney czy DALL-E, zmieniły sposób, w jaki myślimy o interakcji człowieka z komputerem. Te technologie potrafią tworzyć spójne teksty, generować realistyczne obrazy na podstawie prostych opisów, a nawet komponować muzykę. To pokazuje, jak daleko zaszliśmy od prostych Perceptronów, wkraczając w erę, gdzie maszyny nie tylko przetwarzają informacje, ale także twórczo je generują.

Przeczytaj również: Gogle VR: Czy naprawdę psują wzrok? Jak chronić oczy?

Sztuczna inteligencja dzisiaj: dziedzictwo pionierów i przyszłość AI

Dziedzictwo pionierów AI, od Turinga po Hintona, jest dziś widoczne w każdym aspekcie naszego życia. Sztuczna inteligencja stała się integralną częścią naszej codzienności, często niezauważalną. To dzięki niej nasze smartfony rozpoznają mowę i twarze, systemy rekomendacyjne w serwisach streamingowych i sklepach internetowych podpowiadają nam, co oglądać lub kupować, a asystenci głosowi, tacy jak Siri czy Google Assistant, pomagają nam w codziennych zadaniach. W medycynie AI wspiera diagnostykę obrazową, pomaga w odkrywaniu nowych leków i personalizuje terapie, co jeszcze kilka dekad temu było czystą fantastyką.

Polska aktywnie uczestniczy w globalnej rewolucji AI. Mamy wiele kluczowych ośrodków badawczych na uczelniach takich jak Uniwersytet Warszawski, Politechnika Warszawska czy Akademia Górniczo-Hutnicza, które prowadzą zaawansowane projekty. Polskie firmy i startupy odnoszą sukcesy w dziedzinie AI, tworząc innowacyjne rozwiązania, na przykład w przetwarzaniu języka naturalnego (NLP) dla języka polskiego, wizji komputerowej czy zastosowaniach AI w przemyśle. Wsparcie rządowe i unijne dla innowacji w tej dziedzinie przekłada się na rosnącą liczbę specjalistów i ambitnych projektów, co napawa mnie optymizmem co do przyszłości AI w naszym kraju.