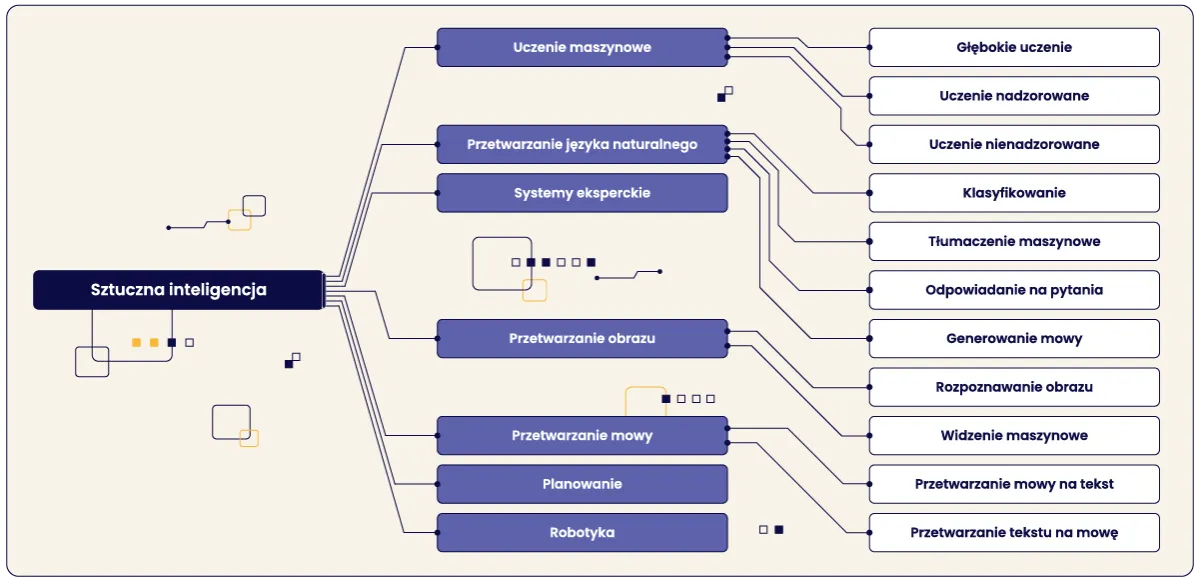

Sztuczna inteligencja słyszy i rozumie świat dźwięków oto jak to robi

- AI "słyszy" dzięki technologiom ASR (rozpoznawanie mowy) i NLP (przetwarzanie języka naturalnego), wspieranym przez uczenie maszynowe.

- Analizuje nie tylko treść słów, ale też mówcę, intencje, emocje oraz dźwięki otoczenia.

- Znajduje zastosowanie w asystentach głosowych, obsłudze klienta, transkrypcji, medycynie i klonowaniu głosu (np. ElevenLabs).

- Przyszłość to dominacja interfejsów głosowych i hiper-personalizacja interakcji.

- Wyzwania obejmują kwestie prywatności, deepfake audio i nowe formy oszustw.

Maszyny naprawdę słuchają: odkrywamy zmysł słuchu sztucznej inteligencji

Od fali dźwiękowej do zrozumienia: jak AI przekształca mowę w dane?

Kiedy wypowiadamy słowa, generujemy falę dźwiękową sygnał analogowy, który rozchodzi się w powietrzu. Dla sztucznej inteligencji ten sygnał jest punktem wyjścia. Pierwszym krokiem jest jego digitalizacja, czyli przekształcenie w dane cyfrowe, które maszyna może przetwarzać. Systemy AI rozkładają tę cyfrową reprezentację mowy na mniejsze, podstawowe jednostki, zwane fonemami to najmniejsze elementy dźwiękowe, które odróżniają znaczenie słów w danym języku. Następnie, wykorzystując zaawansowane modele akustyczne i językowe, AI porównuje te fonemy ze wzorcami zapisanymi w swojej bazie danych. To właśnie ten proces pozwala na konwersję płynnej mowy w zrozumiały dla komputera tekst, otwierając drzwi do dalszej analizy i interpretacji.

Kluczowe technologie: Czym są ASR i NLP i dlaczego zrewolucjonizowały świat audio?

Automatyczne Rozpoznawanie Mowy (ASR Automatic Speech Recognition) to technologia, która stanowi fundament "słuchu" sztucznej inteligencji. Jej głównym zadaniem jest przekształcenie wypowiedzianych słów, czyli sygnału audio, w tekst. To właśnie ASR pozwala naszym smartfonom zrozumieć, co do nich mówimy, kiedy wydajemy polecenia głosowe, lub automatycznie generować napisy do filmów. Bez tej technologii, cała interakcja głosowa z maszynami byłaby niemożliwa, a jej ciągły rozwój rewolucjonizuje sposób, w jaki komunikujemy się z cyfrowym światem.

Gdy ASR zamieni mowę na tekst, do akcji wkracza Przetwarzanie Języka Naturalnego (NLP Natural Language Processing). To właśnie NLP jest "mózgiem", który pozwala AI nie tylko odczytać słowa, ale przede wszystkim zrozumieć ich znaczenie, kontekst, a nawet intencję stojącą za wypowiedzią. Dzięki NLP, asystent głosowy wie, że "ustaw budzik na 7 rano" to polecenie, a "jaka będzie pogoda?" to pytanie o informację. To NLP sprawia, że interakcje z AI stają się coraz bardziej naturalne i zbliżone do rozmowy z człowiekiem, co jest prawdziwą rewolucją w świecie audio.

Mózg operacji: Rola uczenia maszynowego w nauce "słyszenia"

Za kulisami tych wszystkich procesów stoi uczenie maszynowe, a w szczególności głębokie sieci neuronowe, które są prawdziwym mózgiem operacji. To właśnie one stanowią fundament nowoczesnych systemów ASR i NLP. Modele te są trenowane na ogromnych zbiorach danych, składających się z milionów godzin nagrań audio i miliardów słów tekstu. Dzięki temu procesowi, AI uczy się rozpoznawać wzorce w mowie, radzić sobie z różnymi akcentami, dialektami, a nawet filtrować szum tła. Im więcej danych "przesłucha" i "przeczyta" system, tym dokładniejszy się staje, nieustannie poprawiając swoją zdolność do rozumienia i interpretowania ludzkiej mowy. To właśnie ciągłe uczenie się sprawia, że AI jest w stanie dostosować się do naszej różnorodności językowej i akustycznej.

Co trafia do "ucha" AI: zaskakujący zakres analizy dźwięku

Nie tylko słowa: Jak AI rozpoznaje, kto mówi i w jakim nastroju?

To, co dla nas, ludzi, jest intuicyjne, dla AI staje się przedmiotem zaawansowanej analizy. Systemy sztucznej inteligencji nie ograniczają się jedynie do transkrypcji słów. Potrafią również przeprowadzić tzw. diaryzację, czyli zidentyfikować, kto mówi w nagraniu, nawet jeśli jest tam wiele osób. Dzięki temu wiesz, że to ja, Gabriel Błaszczyk, mówię w tym momencie, a nie ktoś inny. To niezwykle przydatne w analizie spotkań czy rozmów telefonicznych, gdzie ważne jest przypisanie wypowiedzi do konkretnego mówcy.

Co więcej, AI potrafi analizować sentyment, czyli ocenić ton emocjonalny wypowiedzi. Czy mówca jest zadowolony, zirytowany, neutralny, a może zmartwiony? Ta zdolność jest kluczowa w branżach takich jak call center, gdzie analiza emocji klienta pozwala na szybką reakcję i poprawę jakości obsługi. Dzięki temu możemy lepiej zrozumieć potrzeby i frustracje naszych klientów, co przekłada się na bardziej efektywne rozwiązywanie problemów.

Rozpoznawanie intencji: Od prostego polecenia do zrozumienia złożonych potrzeb

Jedną z najbardziej fascynujących zdolności AI audio jest rozpoznawanie intencji. Nie chodzi tylko o to, co mówimy, ale po co to mówimy. Asystenci głosowi, tacy jak Siri czy Google Assistant, są tego doskonałym przykładem. Proste polecenia, jak "ustaw budzik na siódmą rano" czy "jaka jest pogoda w Warszawie?", są dla nich chlebem powszednim. Jednak coraz częściej AI radzi sobie ze złożonymi potrzebami, potrafiąc wywnioskować, że "jestem głodny" może oznaczać prośbę o znalezienie najbliższej restauracji, a "chciałbym obejrzeć coś ciekawego" sugestię filmu dopasowanego do naszych preferencji. To pokazuje, jak daleko zaszliśmy w tworzeniu systemów, które naprawdę próbują zrozumieć nasze zamiary.Słuch absolutny na dźwięki otoczenia: Od tłuczonego szkła po płacz dziecka

Poza mową ludzką, zaawansowane systemy AI rozwijają "słuch absolutny" na dźwięki otoczenia. Potrafią identyfikować i klasyfikować szeroki zakres dźwięków innych niż ludzka mowa, co ma ogromne znaczenie w wielu dziedzinach. Wyobraźmy sobie systemy bezpieczeństwa, które automatycznie wykrywają:

- tłuczone szkło,

- strzały z broni palnej,

- alarmy samochodowe,

- płacz dziecka,

- szczekanie psa.

Słyszymy ją na co dzień: praktyczne zastosowania AI audio w Polsce i na świecie

Twój osobisty asystent: Jak działają Siri i Google Assistant?

Asystenci głosowi tacy jak Google Assistant, Siri czy Amazon Alexa stały się nieodłączną częścią naszego codziennego życia. To właśnie oni są najbardziej widocznym przykładem działania technologii ASR i NLP. Kiedy mówimy "Hej Google, jaka jest pogoda?", ASR najpierw konwertuje naszą mowę na tekst, a następnie NLP analizuje to zapytanie, rozumie intencję i wyszukuje odpowiedź. Dzięki temu możemy sterować inteligentnymi urządzeniami w domu, wyszukiwać informacje, wysyłać wiadomości czy zarządzać kalendarzem, wszystko za pomocą głosu. To wygoda, która jeszcze dekadę temu wydawała się science fiction.

„Dzień dobry, w czym mogę pomóc? ” AI w obsłudze klienta i call center

Branża obsługi klienta to kolejny obszar, gdzie AI audio odgrywa kluczową rolę. Voiceboty i chatboty, zasilane przez ASR i NLP, automatyzują procesy w call center, odpowiadając na rutynowe pytania klientów 24 godziny na dobę, 7 dni w tygodniu. Dzięki temu konsultanci mogą skupić się na bardziej złożonych problemach. Co więcej, AI analizuje rozmowy telefoniczne w czasie rzeczywistym, oceniając sentyment klienta, wykrywając kluczowe słowa i identyfikując problemy. Pozwala to firmom na stałe monitorowanie i poprawę jakości obsługi, a także na personalizację ofert, co przekłada się na większą satysfakcję klientów.

Od podcastu do filmu: Automatyczna transkrypcja i napisy na wyciągnięcie ręki

Automatyczna transkrypcja to jedno z najbardziej praktycznych zastosowań AI audio, które ułatwia życie wielu osobom. Dzięki tej technologii możemy w mgnieniu oka zamienić nagrania audio i wideo spotkania biznesowe, wywiady, wykłady, podcasty czy filmy w tekst. To nie tylko ogromna wygoda dla dziennikarzy, studentów czy twórców treści, ale także kluczowy element w zapewnianiu dostępności. Automatycznie generowane napisy sprawiają, że treści są dostępne dla osób niesłyszących lub niedosłyszących, a także dla tych, którzy wolą oglądać wideo bez dźwięku. To pokazuje, jak AI może służyć inkluzywności i demokratyzacji informacji.

Polski jednorożec w czołówce: Fenomen ElevenLabs i rewolucja w klonowaniu głosu

Z dumą mogę powiedzieć, że Polska ma swojego "jednorożca" w dziedzinie AI audio firmę ElevenLabs. To prawdziwy światowy lider w syntezie i klonowaniu głosu, który w krótkim czasie zrewolucjonizował sposób, w jaki myślimy o generowaniu mowy. Ich technologia pozwala na tworzenie niezwykle realistycznych głosów, które trudno odróżnić od ludzkich, a także na klonowanie istniejących głosów z zadziwiającą precyzją. Dzięki temu branża rozrywkowa zyskuje nowe możliwości w tworzeniu audiobooków, dubbingu filmów i gier, a także w personalizacji treści. ElevenLabs to dowód na to, że polska myśl technologiczna ma realny wpływ na globalny rynek AI.

AI na straży zdrowia i bezpieczeństwa: Innowacje od medycyny po monitoring

AI audio znajduje również innowacyjne zastosowania w medycynie. Przykładem jest polski startup StethoMe, który stworzył cyfrowy stetoskop zintegrowany z AI. System ten analizuje dźwięki z płuc i serca, pomagając we wczesnym wykrywaniu problemów zdrowotnych, co może być ratunkiem dla wielu pacjentów. Lekarze coraz częściej wykorzystują również transkrypcję mowy do dyktowania notatek medycznych, co przyspiesza pracę i minimalizuje ryzyko błędów.

W dziedzinie bezpieczeństwa, AI audio staje się cichym strażnikiem. Zaawansowane systemy monitoringu potrafią analizować dźwięki otoczenia w poszukiwaniu anomalii, takich jak odgłosy strzałów, tłuczonego szkła czy alarmów. Dzięki temu mogą automatycznie powiadamiać służby ratunkowe o potencjalnych zagrożeniach, zanim jeszcze zostaną one wizualnie zidentyfikowane. To pokazuje, jak AI może znacząco zwiększyć nasze poczucie bezpieczeństwa w przestrzeni publicznej i prywatnej.

Głos przyszłości: zmiany, które czekają nas do 2026 roku

Koniec ery ekranów? Dlaczego interfejsy głosowe zdominują naszą przyszłość

Jestem przekonany, że w ciągu najbliższych kilku lat interfejsy głosowe zdominują sposób, w jaki wchodzimy w interakcje z technologią. Ekrany, choć wciąż ważne, zaczną odgrywać drugorzędną rolę, ustępując miejsca naturalnej, głosowej komunikacji. Już teraz giganci tacy jak OpenAI intensywnie pracują nad asystentami głosowymi nowej generacji, które będą w stanie prowadzić płynne, kontekstowe rozmowy, niemal nierozróżnialne od interakcji z człowiekiem. Wyobraźmy sobie świat, w którym nasze urządzenia rozumieją nas bezbłędnie, przewidują nasze potrzeby i reagują na nasze polecenia, zanim jeszcze zdążymy je w pełni wypowiedzieć. To nie jest odległa przyszłość, to trend, który już się dzieje.

Rozmowa jak z człowiekiem: Ku jeszcze bardziej naturalnej i spersonalizowanej interakcji

Kierunek, w którym zmierza AI audio, to hiper-personalizacja i maksymalne upodobnienie interakcji do rozmowy z człowiekiem. Systemy będą jeszcze lepiej rozumieć nie tylko słowa, ale cały kontekst, nasze indywidualne preferencje, historię naszych interakcji, a nawet nasz nastrój. Oznacza to, że asystent głosowy będzie w stanie dostosować swoje odpowiedzi i zachowanie do naszej osobowości, oferując nam doświadczenie, które będzie nie tylko efektywne, ale i przyjemne. Wyobrażam sobie, że wkrótce będziemy rozmawiać z AI tak naturalnie, jak z bliskim znajomym, a technologia będzie niemal niewidoczna, płynnie wtapiając się w nasze codzienne życie.

Nowe możliwości, nowe wyzwania: Jak technologia AI audio wpłynie na rynek pracy?

Rozwój technologii AI audio, podobnie jak każda rewolucja technologiczna, przyniesie ze sobą zarówno nowe możliwości, jak i wyzwania dla rynku pracy. Z jednej strony, możemy spodziewać się powstania wielu nowych zawodów związanych z projektowaniem, trenowaniem i utrzymywaniem systemów głosowych, analityką danych audio czy tworzeniem treści z wykorzystaniem syntezy mowy. Z drugiej strony, niektóre rutynowe zadania, takie jak obsługa klienta czy transkrypcja, mogą zostać zautomatyzowane, co wymaga od pracowników adaptacji i przekwalifikowania. Kluczem będzie umiejętność współpracy z AI i wykorzystywanie jej do zwiększania własnej produktywności, a nie postrzeganie jej jako zagrożenia. Jestem przekonany, że rynek pracy będzie ewoluował, tworząc nowe nisze dla ludzkiej kreatywności i umiejętności, których maszyny nie są w stanie zastąpić.

Ciemna strona dźwięku: zagrożenia związane ze słuchającą AI

Gdy nie możesz ufać własnym uszom: Czym jest deepfake audio i jak się przed nim bronić?

Niestety, każda potężna technologia ma swoją ciemną stronę. Deepfake audio to przerażający przykład, jak technologia klonowania głosu może być wykorzystana do tworzenia fałszywych nagrań, które są niemal niemożliwe do odróżnienia od prawdziwych. Wyobraźmy sobie, że słyszymy głos bliskiej osoby proszącej o pilny przelew, albo polityka wypowiadającego się w sposób, który nigdy nie miał miejsca. Zagrożenia związane z dezinformacją, podszywaniem się i manipulacją są ogromne. Aby się bronić, musimy być niezwykle ostrożni, weryfikować źródła informacji, a w przypadku podejrzanych próśb o pieniądze zawsze kontaktować się z osobą bezpośrednio, używając innego kanału komunikacji. Edukacja i świadomość to nasza najlepsza obrona.

Kwestie prywatności: Kto i po co gromadzi nasze dane głosowe?

Wraz z rosnącą obecnością AI audio w naszym życiu, pojawiają się poważne pytania dotyczące prywatności. Kiedy rozmawiamy z asystentami głosowymi, korzystamy z voicebotów czy nawet po prostu nagrywamy wiadomości, nasze dane głosowe są gromadzone i analizowane. Kto ma do nich dostęp? W jakim celu są wykorzystywane? Czy są bezpieczne? Te pytania są kluczowe. Firmy technologiczne często wykorzystują te dane do ulepszania swoich modeli, personalizacji usług czy celów marketingowych. Jako użytkownicy, musimy być świadomi polityk prywatności, z których korzystamy, i domagać się większej przejrzystości oraz kontroli nad tym, jak nasze dane głosowe są przechowywane i przetwarzane. Moja rada: zawsze czytajcie warunki użytkowania i zastanówcie się, czy zgadzacie się na udostępnianie swoich danych.

Czy czeka nas fala "vishing"? Nowe metody oszustw z użyciem syntetycznego głosu

Rozwój syntetycznych głosów otwiera niestety nowe, niebezpieczne możliwości dla oszustów. Już teraz obserwujemy zjawisko phishingu głosowego, czyli "vishingu", gdzie przestępcy wykorzystują zaawansowane technologie do podszywania się pod banki, instytucje rządowe czy nawet bliskich nam ludzi. Wyobraźmy sobie telefon od "wnuczka", którego głos brzmi identycznie jak prawdziwy, proszącego o pilną pomoc finansową. Syntetyczne głosy mogą być używane do wyłudzania danych osobowych, numerów kart kredytowych czy haseł, a ich realistyczność sprawia, że jesteśmy bardziej podatni na manipulację. Musimy być czujni i pamiętać, że instytucje nigdy nie proszą o wrażliwe dane przez telefon, a w przypadku podejrzanych połączeń zawsze należy weryfikować tożsamość dzwoniącego u źródła, korzystając z oficjalnych numerów kontaktowych.

Słuchać, ale czy rozumieć? Możliwości i granice percepcji AI

Co już potrafimy, a co wciąż jest poza zasięgiem maszyn?

Podsumowując, sztuczna inteligencja osiągnęła imponujące postępy w zakresie słuchania i rozumienia dźwięku. Potrafimy już automatycznie transkrybować mowę z wysoką dokładnością, identyfikować mówców, analizować sentyment, a nawet rozpoznawać intencje i dźwięki otoczenia. Jednak wciąż istnieją granice. Hałaśliwe otoczenie, nietypowe akcenty, dialekty czy bardzo złożone, wieloznaczne konteksty ludzkiej mowy nadal stanowią wyzwanie. AI wciąż ma trudności z głębokim rozumieniem niuansów, ironii, sarkazmu czy emocji, które są subtelne i wymagają prawdziwie ludzkiej empatii i doświadczenia. To pokazuje, że choć maszyny słyszą, to pełne, ludzkie rozumienie wciąż pozostaje poza ich zasięgiem, przynajmniej na razie.

Przeczytaj również: Jak podłączyć gogle VR do PC? Krok po kroku (Meta Quest, Pico)

Etyczny wymiar słuchania: Jak odpowiedzialnie rozwijać technologie audio AI?

W obliczu tak dynamicznego rozwoju technologii audio AI, niezwykle ważne staje się odpowiedzialne podejście do jej rozwoju i wdrażania. Musimy pamiętać o etycznym wymiarze "słuchania" przez maszyny. Kwestie prywatności, bezpieczeństwa danych, potencjalne zagrożenia związane z deepfake audio czy vishingiem wymagają od nas nie tylko technologicznych zabezpieczeń, ale także klarownych regulacji prawnych. Unijny AI Act, który ma na celu uregulowanie sztucznej inteligencji, to krok w dobrym kierunku. Jako twórcy i użytkownicy tej technologii, musimy dbać o to, aby rozwijać ją w sposób, który służy dobru wspólnemu, chroni prawa jednostki i buduje zaufanie, a nie podważa je. Tylko w ten sposób możemy wykorzystać pełny potencjał AI audio, minimalizując jednocześnie związane z nią ryzyka.