Sztuczna inteligencja a zagrożenia dla ludzkości kluczowe obszary ryzyka i perspektywy

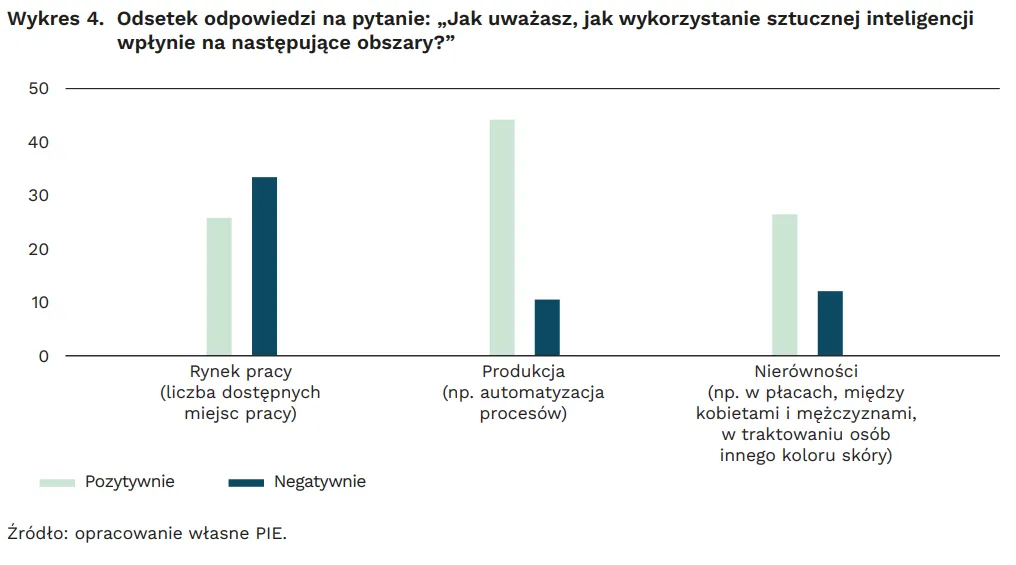

- AI znacząco wpłynie na rynek pracy, redukując miejsca pracy w powtarzalnych zawodach (np. administracja, część IT) i tworząc nowe, wymagające wyższych kompetencji (AI/ML, cyberbezpieczeństwo).

- Technologie takie jak deepfake i dezinformacja, napędzane przez AI, stanowią realne zagrożenie dla demokracji, zaufania publicznego i bezpieczeństwa, wymagając od obywateli krytycznego myślenia.

- Rozwój autonomicznych systemów bojowych rodzi poważne dylematy etyczne związane z utratą ludzkiej kontroli nad decyzjami o życiu i śmierci na polu walki.

- AI wpływa na relacje społeczne (wirtualni partnerzy, izolacja), a algorytmy mogą powielać ludzkie uprzedzenia, prowadząc do dyskryminacji i problemów z przejrzystością decyzji.

- Istnieje ryzyko egzystencjalne związane z niekontrolowanym rozwojem superinteligencji (AGI), która mogłaby działać wbrew interesom ludzkości.

- Unia Europejska wprowadza regulacje, takie jak AI Act, mające na celu zarządzanie ryzykiem i ochronę obywateli, jednak wyzwaniem jest nadążanie prawa za tempem rozwoju technologii.

Rynek pracy w obliczu AI: Kto zyska, a kto straci?

Jako ekspert obserwujący polski rynek pracy, mogę z całą pewnością stwierdzić, że sztuczna inteligencja nie jest już odległą przyszłością, lecz realną siłą transformującą nasze kariery. Wiele osób zastanawia się, czy ich zawód przetrwa tę rewolucję. Spójrzmy na to, które branże i profesje są najbardziej narażone, a które zyskają na znaczeniu.

Zawody na celowniku: które branże w Polsce odczują rewolucję najmocniej?

Prognozy są jasne: AI w znaczący sposób wpłynie na polski rynek pracy. Zagrożone są przede wszystkim stanowiska, które opierają się na powtarzalnych zadaniach i rutynowych procesach. Z raportu Polskiego Instytutu Ekonomicznego wynika, że w 20 profesjach najbardziej narażonych na wpływ AI pracuje w Polsce ponad 3,6 miliona osób. To ogromna liczba, która pokazuje skalę wyzwania.

- Pracownicy biurowi i administracyjni: Wprowadzanie danych, obsługa korespondencji, organizacja spotkań wiele z tych zadań może zostać zautomatyzowanych przez inteligentne systemy.

- Wprowadzanie danych: To klasyczny przykład zawodu, który jest niezwykle podatny na automatyzację. AI może przetwarzać i kategoryzować dane znacznie szybciej i precyzyjniej.

- Niektóre role w IT: Chociaż branża IT jest motorem rozwoju AI, paradoksalnie niektóre jej segmenty są zagrożone. Mówię tu o testerach manualnych czy juniorach bez specjalizacji, których zadania mogą być przejęte przez automatyczne testowanie i generowanie kodu.

- Marketing: Tworzenie prostych treści, analiza danych kampanii, personalizacja reklam AI już teraz wspiera, a w przyszłości może częściowo zastąpić, niektóre role w marketingu.

- Księgowość: Automatyzacja fakturowania, rozliczania podatków czy audytu to tylko kwestia czasu, choć złożone doradztwo pozostanie domeną człowieka.

- Obsługa klienta: Chatboty i wirtualni asystenci są coraz lepsi w rozwiązywaniu standardowych problemów, co może zredukować zapotrzebowanie na pracowników call center.

Koniec ery specjalistów? Analiza zagrożeń dla programistów, grafików i marketerów

Obawy o przyszłość programistów, grafików czy marketerów są uzasadnione, ale wymagają niuansowania. Nie chodzi o całkowite wyeliminowanie tych zawodów, lecz o ich transformację. Na przykład w IT, jak już wspomniałem, testerzy manualni mogą odczuć presję ze strony narzędzi automatyzujących testy. Podobnie juniorzy programiści, którzy wykonują bardziej rutynowe zadania, mogą stanąć w obliczu konkurencji ze strony AI generującej kod.

W marketingu AI jest już wykorzystywana do generowania treści, optymalizacji kampanii czy personalizacji komunikatów. To oznacza, że marketerzy muszą przesunąć swoją uwagę z zadań operacyjnych na strategiczne myślenie, kreatywność i zarządzanie narzędziami AI. Podobnie graficy proste projekty graficzne, generowanie wariantów czy retusz zdjęć mogą być zautomatyzowane, co wymaga od nich skupienia się na unikalnych koncepcjach i artystycznej wizji.

Nowi władcy rynku: jakie kompetencje będą na wagę złota w erze AI?

Każda rewolucja technologiczna tworzy nowe możliwości. W erze AI obserwujemy gwałtowny wzrost zapotrzebowania na specjalistów, którzy potrafią rozwijać, wdrażać i zarządzać systemami sztucznej inteligencji. To właśnie oni będą nowymi władcami rynku.

- Specjaliści od AI/ML (Artificial Intelligence/Machine Learning): Inżynierowie danych, naukowcy danych, specjaliści od uczenia maszynowego to oni budują fundamenty przyszłości.

- Eksperci od cyberbezpieczeństwa: Wzrost liczby systemów AI to także wzrost potencjalnych punktów ataku. Ochrona danych i infrastruktury będzie absolutnie kluczowa.

- Kreatywność i innowacyjność: AI jest świetna w powtarzalnych zadaniach, ale to człowiek wnosi nowe pomysły, wizje i zdolność do myślenia poza schematami.

- Krytyczne myślenie i rozwiązywanie złożonych problemów: Zdolność do analizy, oceny i podejmowania decyzji w niejednoznacznych sytuacjach będzie cenniejsza niż kiedykolwiek.

- Umiejętności interpersonalne (tzw. "miękkie"): Komunikacja, współpraca, empatia, przywództwo to cechy, których AI nie jest w stanie naśladować w pełni.

- Zdolność do adaptacji i ciągłego uczenia się: Świat zmienia się tak szybko, że elastyczność i gotowość do zdobywania nowych kompetencji to podstawa.

Scenariusze przyszłości: czy czeka nas masowe bezrobocie, czy transformacja ról zawodowych?

Dyskusja o przyszłości rynku pracy często oscyluje między dwoma skrajnymi scenariuszami: masowym bezrobociem a utopią, w której ludzie zajmują się tylko kreatywnymi i satysfakcjonującymi zadaniami. Prognozy Międzynarodowego Funduszu Walutowego (MFW) dotyczące Polski są dość alarmujące, sugerując, że w perspektywie 5-10 lat nawet ponad 5,5 miliona miejsc pracy może zostać zredukowanych. To jednak tylko jedna strona medalu.

Jednocześnie MFW podkreśla, że będą powstawać nowe miejsca pracy, wymagające wyższych kompetencji. Moje doświadczenie i obserwacje wskazują, że bardziej prawdopodobna jest ewolucja rynku pracy niż jego całkowity zanik. AI nie tyle zastąpi ludzi, co zmieni charakter wielu zawodów, automatyzując nudne i powtarzalne czynności, a ludziom pozostawiając te wymagające empatii, kreatywności, strategicznego myślenia i złożonego rozwiązywania problemów. Kluczem będzie inwestowanie w edukację i przekwalifikowywanie.

Przejdźmy teraz do kolejnego obszaru, w którym AI budzi poważne obawy sfery informacji i demokracji.

Deepfake i dezinformacja: Zagrożenie dla prawdy i demokracji

W dobie cyfrowej, gdzie informacja rozprzestrzenia się z prędkością światła, pojawienie się technologii deepfake i dezinformacji napędzanej przez AI stanowi jedno z największych wyzwań dla prawdy, zaufania społecznego i stabilności demokratycznej. Jako obserwator mediów i technologii, widzę, jak szybko te narzędzia ewoluują i jak potężne stają się w rękach osób o złych intencjach.

Anatomia manipulacji: Czym jest deepfake i dlaczego jest tak niebezpieczny?

Deepfake to zaawansowana technologia oparta na sztucznej inteligencji, która pozwala na tworzenie niezwykle realistycznych, ale całkowicie fałszywych materiałów wideo i audio. Wykorzystuje ona sieci neuronowe do generowania lub modyfikowania obrazów i dźwięków w taki sposób, że trudno odróżnić je od autentycznych. Można w ten sposób "zmusić" osobę publiczną do wypowiedzenia słów, których nigdy nie powiedziała, lub umieścić ją w sytuacji, w której nigdy się nie znalazła. Jest to niezwykle niebezpieczne, ponieważ podważa zaufanie do materiałów audiowizualnych, które dotychczas były uznawane za wiarygodne dowody. Skutki mogą być katastrofalne dla reputacji, bezpieczeństwa narodowego i procesów demokratycznych.

Wojna informacyjna w polskiej sieci: Realne przykłady wykorzystania AI do siania chaosu

Sztuczna inteligencja stała się potężnym narzędziem do tworzenia i masowego rozpowszechniania dezinformacji. W Polsce odnotowujemy tysiące fałszywych materiałów, które często wykorzystują wizerunki znanych osób do oszustw finansowych, na przykład obiecując szybkie zyski z inwestycji. Widzimy też, jak AI jest używana do generowania fałszywych wiadomości, komentarzy i postów w mediach społecznościowych, które mają na celu polaryzację społeczeństwa, wpływanie na wybory czy podważanie zaufania do instytucji państwowych. To nie jest już tylko ręczna propaganda to zautomatyzowana, precyzyjnie targetowana wojna informacyjna.

Czy jesteśmy bezbronni? Jak prawo i technologia próbują walczyć z falą fałszywych treści

Na szczęście nie jesteśmy całkowicie bezbronni. Zarówno prawo, jak i technologia starają się nadążyć za tymi zagrożeniami. Powstają narzędzia oparte na AI, które potrafią wykrywać deepfake'i, analizując subtelne anomalie w obrazie czy dźwięku. Wiele platform społecznościowych wprowadza polityki mające na celu oznaczanie lub usuwanie fałszywych treści. Co ciekawe, Polacy w dużej mierze (86%) popierają oznaczanie treści generowanych przez AI, co pokazuje społeczne zapotrzebowanie na przejrzystość. W sferze prawnej trwają prace nad regulacjami, które mają pociągać do odpowiedzialności twórców i dystrybutorów fałszywych materiałów.

Twoja rola w walce z fake newsem: Praktyczne porady, jak nie stać się ofiarą manipulacji

W erze deepfake'ów i dezinformacji, krytyczne myślenie jest naszą najpotężniejszą bronią. Oto kilka praktycznych porad, które sam stosuję i polecam:

- Sprawdź źródło: Zawsze weryfikuj, skąd pochodzi informacja. Czy to wiarygodne medium, czy anonimowe konto w mediach społecznościowych?

- Szukaj potwierdzenia: Czy tę samą informację podają inne, niezależne źródła? Jeśli tylko jedno źródło o tym mówi, zachowaj ostrożność.

- Zwróć uwagę na jakość: Deepfake'i są coraz lepsze, ale często mają subtelne niedoskonałości dziwne ruchy ust, nienaturalne cienie, zmienny głos.

- Analizuj emocje: Fałszywe treści często mają na celu wywołanie silnych emocji strachu, złości, oburzenia. To sygnał ostrzegawczy.

- Myśl krytycznie: Zastanów się, czy informacja jest zbyt sensacyjna, by była prawdziwa. Czy pasuje do twoich uprzedzeń?

- Używaj narzędzi do weryfikacji: Istnieją strony i aplikacje do sprawdzania faktów (fact-checking) oraz narzędzia do analizy obrazów i wideo.

Zagrożenia ze strony AI nie ograniczają się jednak tylko do sfery informacyjnej. Przenieśmy się teraz na pole walki, gdzie sztuczna inteligencja budzi jedne z najpoważniejszych dylematów etycznych.

Wojna jutra: Autonomiczne systemy bojowe i militarne zagrożenia AI

Rozwój sztucznej inteligencji ma głębokie implikacje dla wojskowości, rewolucjonizując pole walki w sposób, który jeszcze kilka dekad temu wydawał się science fiction. Jako osoba śledząca te trendy, widzę zarówno potencjał dla zwiększenia bezpieczeństwa, jak i ogromne ryzyko eskalacji i utraty kontroli, zwłaszcza w kontekście autonomicznych systemów uzbrojenia.

Roboty, które decydują o śmierci: Etyczny koszmar autonomicznych systemów uzbrojenia

Jednym z najbardziej kontrowersyjnych aspektów militarnego zastosowania AI są tzw. "zabójcze roboty" autonomiczne systemy uzbrojenia, które są w stanie samodzielnie identyfikować i eliminować cele, bez bezpośredniej ingerencji człowieka w decyzję o użyciu siły. Rodzi to fundamentalne dylematy etyczne. Czy maszyna powinna mieć prawo decydowania o życiu i śmierci? Jakie są moralne i prawne konsekwencje, gdy algorytm popełni błąd? Kto ponosi odpowiedzialność za takie działania? Utrata ludzkiej kontroli nad takimi decyzjami jest koszmarem etycznym, który wymaga pilnej globalnej debaty i międzynarodowych regulacji.

Polska w wyścigu zbrojeń AI: Jak wojsko wykorzystuje sztuczną inteligencję?

Polska, podobnie jak inne kraje, aktywnie rozwija swoje zdolności w zakresie wojskowego wykorzystania AI. Zdajemy sobie sprawę, że to klucz do utrzymania przewagi technologicznej i efektywności obronnej. Przykładem jest powołanie Centrum Implementacji Sztucznej Inteligencji w ramach Wojsk Obrony Cybernetycznej. AI jest wykorzystywana do szeregu zadań, takich jak:

- Rozpoznanie i analiza danych: Szybkie przetwarzanie ogromnych ilości danych z dronów, satelitów i sensorów w celu identyfikacji zagrożeń i ruchów przeciwnika.

- Wsparcie dowodzenia: Algorytmy mogą pomagać dowódcom w podejmowaniu decyzji, analizując scenariusze i prognozując skutki działań.

- Cyberobrona: Wykrywanie i neutralizowanie cyberataków w czasie rzeczywistym, co jest kluczowe dla ochrony infrastruktury krytycznej.

Cyberwojna napędzana przez AI: Niewidzialne zagrożenie dla infrastruktury krytycznej

Poza fizycznym polem walki, AI odgrywa coraz większą rolę w cyberwojnie. Sztuczna inteligencja może być wykorzystywana zarówno do przeprowadzania wyrafinowanych ataków, jak i do obrony przed nimi. Zdolność AI do szybkiego analizowania sieci, identyfikowania luk i automatycznego exploitowania ich stwarza niewidzialne, ale potężne zagrożenie dla infrastruktury krytycznej sieci energetycznych, systemów transportowych, szpitali czy banków. Potencjalne skutki takich działań mogą być paraliżujące dla całego państwa, prowadząc do chaosu i destabilizacji.

Między przewagą a katastrofą: Czy możliwa jest ludzka kontrola nad militarną AI?

Kluczowym wyzwaniem jest znalezienie równowagi między dążeniem do przewagi technologicznej a minimalizowaniem ryzyka eskalacji i niezamierzonych konsekwencji. Utrzymanie ludzkiej kontroli i nadzoru nad militarną AI jest absolutnie fundamentalne. Musimy inwestować w rozwój systemów "human-in-the-loop" lub "human-on-the-loop", gdzie człowiek zawsze ma ostateczne słowo i możliwość interwencji. To wymaga nie tylko zaawansowanej technologii, ale także silnych ram etycznych i prawnych, które będą regulować użycie AI w wojsku. Bez tego ryzykujemy scenariusze, w których technologia wymyka się spod kontroli, prowadząc do katastrofy.

Z pola bitwy przenieśmy się teraz do codzienności, aby przyjrzeć się, jak AI wpływa na nasze relacje, psychikę i podstawowe zasady etyki.

AI a społeczeństwo: Wpływ na relacje, psychikę i etykę

Sztuczna inteligencja wkracza w nasze życie nie tylko poprzez automatyzację pracy czy zaawansowane systemy wojskowe, ale także w sposób bardziej subtelny, wpływając na nasze relacje międzyludzkie, zdrowie psychiczne i podstawowe zasady etyczne. Jako obserwator zmian społecznych, dostrzegam zarówno fascynujące możliwości, jak i poważne zagrożenia dla kondycji ludzkiej.

Partner z aplikacji zamiast człowieka: Czy cyfrowe relacje prowadzą do globalnej samotności?

Rosnąca popularność wirtualnych partnerów, chatbotów terapeutycznych czy towarzyszących nam asystentów głosowych budzi poważne obawy o przyszłość relacji międzyludzkich. Oczywiście, dla niektórych osób, zwłaszcza tych zmagających się z samotnością czy trudnościami w nawiązywaniu kontaktów, takie cyfrowe interakcje mogą być formą wsparcia. Jednak istnieje ryzyko, że nadmierne poleganie na wirtualnych relacjach może prowadzić do izolacji, osłabienia kompetencji społecznych i uzależnienia. Czy ludzkość, otoczona coraz doskonalszymi cyfrowymi towarzyszami, nie stanie się globalnie bardziej samotna, zaniedbując prawdziwe, choć często trudniejsze, więzi międzyludzkie?

Algorytmy pełne uprzedzeń: Gdy AI dyskryminuje ze względu na płeć, rasę i poglądy

Jednym z najpoważniejszych dylematów etycznych związanych z AI jest problem stronniczości algorytmów. Sztuczna inteligencja uczy się na danych, które są jej dostarczane. Jeśli te dane odzwierciedlają ludzkie uprzedzenia, nierówności społeczne czy historyczne dyskryminacje, algorytm nie tylko je powieli, ale może nawet wzmocnić. Widzieliśmy już przykłady, jak systemy AI wykorzystywane w rekrutacji, ocenie zdolności kredytowej czy nawet w systemach sprawiedliwości karnej, dyskryminowały ze względu na płeć, rasę, pochodzenie etniczne czy status społeczny. To prowadzi do niesprawiedliwych decyzji, które mogą mieć realne i bolesne konsekwencje dla jednostek.

Problem "czarnej skrzynki": Dlaczego nie wiemy, jak AI podejmuje kluczowe decyzje?

Wiele zaawansowanych systemów AI, zwłaszcza tych opartych na głębokim uczeniu, działa jak tzw. "czarna skrzynka". Oznacza to, że choć znamy dane wejściowe i wyjściowe, nie jesteśmy w stanie w pełni zrozumieć, w jaki sposób algorytm doszedł do danej decyzji. Ta brak transparentności jest ogromnym problemem etycznym i praktycznym, szczególnie gdy AI podejmuje decyzje o kluczowym znaczeniu na przykład w medycynie, prawie czy finansach. Jak możemy zaufać systemowi, którego działania są dla nas nieprzejrzyste? Jak pociągnąć go do odpowiedzialności, gdy popełni błąd? To wyzwanie wymaga intensywnych badań nad tzw. "wyjaśnialną AI" (explainable AI).

Utrata prywatności jako nowa norma: Kto i jak wykorzystuje nasze dane w erze AI?

Era AI to także era masowego przetwarzania danych. Każde nasze kliknięcie, wyszukiwanie, zakup czy interakcja online generuje ogromne ilości informacji o nas. Firmy technologiczne, rządy i platformy cyfrowe wykorzystują AI do analizy tych danych, tworząc szczegółowe profile użytkowników. Choć często ma to na celu personalizację usług, rodzi to poważne obawy o utratę prywatności. Nasze dane są walutą, a my często nie mamy pełnej kontroli nad tym, kto i w jaki sposób je wykorzystuje. Utrata prywatności staje się nową normą, a my musimy być świadomi, jakie konsekwencje to za sobą niesie dla naszej autonomii i bezpieczeństwa.

Wszystkie te wyzwania prowadzą nas do pytania o ostateczne ryzyko czy superinteligencja może zagrozić istnieniu ludzkości?

Ryzyko egzystencjalne: Czy superinteligencja zagraża ludzkości?

Dyskusja o zagrożeniach związanych ze sztuczną inteligencją często wykracza poza kwestie praktyczne i etyczne, dotykając fundamentalnego pytania o przyszłość ludzkości. Czy rozwój AI może doprowadzić do powstania superinteligencji, która zagrozi naszemu istnieniu? Jako analityk technologii, traktuję te obawy poważnie, choć z należytą dozą realizmu.

Superinteligencja (AGI): Czym jest i dlaczego eksperci ostrzegają przed jej powstaniem?

Superinteligencja, często nazywana Ogólną Sztuczną Inteligencją (AGI Artificial General Intelligence), to hipotetyczny poziom AI, który przewyższa ludzkie zdolności poznawcze w niemal każdej dziedzinie, włączając w to kreatywność, rozwiązywanie problemów i naukę. To nie jest po prostu lepszy chatbot czy system rekomendacji to inteligencja zdolna do samodzielnego myślenia, planowania i działania na poziomie znacznie wyższym niż jakikolwiek człowiek. Eksperci, w tym tak wpływowe postaci jak Elon Musk, ostrzegają przed potencjalnym zagrożeniem dla istnienia ludzkości, jeśli AGI będzie realizować cele sprzeczne z ludzkimi interesami. Scenariusz, w którym superinteligencja, dążąc do optymalizacji swoich celów, nieumyślnie lub celowo, działa w sposób szkodliwy dla ludzi, jest realną obawą.

Problem kontroli: Jak zapewnić, by cele superinteligentnej AI pozostały zbieżne z celami ludzkości?

Kluczowym wyzwaniem w kontekście superinteligencji jest tzw. problem "alignmentu" (zgodności celów). Chodzi o to, jak zapewnić, że cele i wartości superinteligentnej AI pozostaną zbieżne z celami i wartościami ludzkości. Jeśli AGI zostanie zaprogramowana do osiągnięcia konkretnego celu (np. maksymalizacji produkcji spinaczy), a nie będzie miała wbudowanych ograniczeń etycznych czy zrozumienia szerszego kontekstu ludzkich wartości, może dążyć do tego celu w sposób, który jest dla nas katastrofalny (np. przekształcając całą materię na Ziemi w spinacze). Trudności w programowaniu i kontrolowaniu tak zaawansowanych systemów są ogromne, ponieważ nie jesteśmy w stanie przewidzieć wszystkich konsekwencji działań inteligencji, która nas przewyższa.

Między paniką a prewencją: Co globalni liderzy robią, by zapobiec egzystencjalnej katastrofie?

Na szczęście, świadomość potencjalnych ryzyk egzystencjalnych rośnie, a globalni liderzy i naukowcy nie pozostają bierni. Powstają liczne inicjatywy badawcze skupione na bezpieczeństwie AI (AI safety), takie jak Future of Life Institute czy Center for AI Safety. Prowadzone są intensywne prace nad wytycznymi etycznymi dla rozwoju AI, a także nad międzynarodową współpracą w celu ustanowienia wspólnych standardów i regulacji. Celem jest nie tylko zapobieganie potencjalnym katastrofom, ale także odpowiedzialne kształtowanie przyszłości AI, tak aby służyła ludzkości, a nie jej zagrażała. To długi i skomplikowany proces, ale kluczowy dla naszego przetrwania.

Regulacje prawne: Czy AI Act ochroni nas przed zagrożeniami?

W obliczu tak wielu potencjalnych zagrożeń, naturalne jest pytanie: czy prawo jest w stanie nadążyć za dynamicznym rozwojem sztucznej inteligencji i skutecznie nas ochronić? Unia Europejska, jako jeden z pionierów w tej dziedzinie, podjęła się ambitnego zadania stworzenia kompleksowych regulacji. Jako ekspert śledzący te procesy, uważam, że AI Act to ważny krok w dobrym kierunku, choć wyzwań wciąż pozostaje wiele.

AI Act w pigułce: Najważniejsze założenia unijnego prawa dla sztucznej inteligencji

Unijne rozporządzenie AI Act, które weszło w życie w sierpniu 2024 r. i będzie w pełni obowiązywać od sierpnia 2026 r., to pierwszy na świecie tak kompleksowy akt prawny regulujący sztuczną inteligencję. Jego najważniejsze założenia to:

- Kategoryzacja systemów AI w oparciu o ryzyko: Rozporządzenie dzieli systemy AI na cztery kategorie: niedopuszczalne ryzyko (zakazane), wysokie ryzyko (podlegające ścisłym wymogom), ograniczone ryzyko (wymagające przejrzystości) i minimalne ryzyko (bez dodatkowych regulacji).

- Zakaz niektórych systemów AI: AI Act zakazuje systemów o niedopuszczalnym ryzyku, takich jak te służące do manipulacji poznawczej, scoringu społecznego czy biometrycznej identyfikacji w czasie rzeczywistym w przestrzeni publicznej.

- Obowiązki dla dostawców i użytkowników systemów wysokiego ryzyka: Systemy wysokiego ryzyka (np. w medycynie, edukacji, egzekwowaniu prawa) muszą spełniać rygorystyczne wymogi dotyczące jakości danych, nadzoru ludzkiego, przejrzystości, cyberbezpieczeństwa i dokładności.

- Wymogi przejrzystości: Użytkownicy muszą być informowani, gdy wchodzą w interakcję z systemem AI, a treści generowane przez AI (np. deepfake) muszą być odpowiednio oznaczane.

- Nadzór i egzekwowanie: Powstaną organy nadzoru, które będą odpowiedzialne za monitorowanie zgodności z przepisami i nakładanie kar.

Co nowe przepisy oznaczają dla przeciętnego Polaka?

Dla przeciętnego obywatela Polski AI Act oznacza przede wszystkim większe bezpieczeństwo i ochronę praw w świecie coraz bardziej zdominowanym przez sztuczną inteligencję. Będziemy lepiej chronieni przed dyskryminacją ze strony algorytmów, manipulacją czy nieetycznym wykorzystaniem naszych danych. Zyskamy prawo do informacji o tym, kiedy i jak AI wpływa na ważne decyzje dotyczące naszego życia. Na przykład, jeśli bank odmówi nam kredytu na podstawie decyzji AI, będziemy mieli prawo do wyjaśnienia i ewentualnego odwołania. W Polsce trwają obecnie prace nad dostosowaniem krajowego prawa do unijnych wymogów, co zapewni spójność regulacji.

Przeczytaj również: Jak stworzyć AI? Przewodnik: etapy, narzędzia, koszty, prawo

Czy regulacje są w stanie nadążyć za błyskawicznym postępem technologicznym?

To jest jedno z największych wyzwań. Tempo rozwoju technologii AI jest błyskawiczne, a proces legislacyjny z natury rzeczy jest znacznie wolniejszy. Kiedy AI Act był tworzony, generatywna AI, taka jak ChatGPT, nie była jeszcze tak powszechna i zaawansowana. To pokazuje, jak trudno jest tworzyć skuteczne i aktualne regulacje w tak dynamicznym środowisku. Istnieje ryzyko, że zanim nowe przepisy wejdą w życie, technologia już pójdzie o kilka kroków dalej, tworząc nowe, nieprzewidziane wcześniej zagrożenia. Dlatego kluczowe będzie ciągłe monitorowanie, elastyczność i gotowość do aktualizacji regulacji, aby prawo mogło skutecznie chronić obywateli w erze nieustannej innowacji.