Programowanie AI od podstaw: Twój przewodnik po ścieżce kariery i kluczowych narzędziach

- Python jest niekwestionowanym liderem i fundamentem w programowaniu AI, oferującym bogaty ekosystem bibliotek.

- Niezbędne są solidne podstawy matematyczne, w tym algebra liniowa, rachunek różniczkowy oraz statystyka i prawdopodobieństwo.

- Kluczowe biblioteki to NumPy, Pandas (analiza danych), Scikit-learn (klasyczne ML) oraz TensorFlow/PyTorch (głębokie uczenie).

- Praktyczne projekty i solidne portfolio są absolutnie kluczowe do zdobycia pierwszej pracy, zwłaszcza na polskim rynku.

- Rynek pracy w Polsce charakteryzuje się ogromnym popytem na specjalistów AI/ML i wysokimi zarobkami, ale wymaga praktycznego doświadczenia.

- Ścieżka nauki powinna obejmować: Pythona, analizę danych, klasyczne uczenie maszynowe, a następnie głębokie uczenie.

Kariera w AI: dlaczego teraz jest najlepszy moment?

Jeśli zastanawiasz się, czy warto inwestować czas w naukę programowania AI, odpowiedź jest jednoznaczna: tak, i to właśnie teraz. Obserwuję, jak rynek pracy w Polsce w 2026 roku dosłownie eksploduje, jeśli chodzi o zapotrzebowanie na specjalistów AI/ML. To już nie jest nisza, to mainstream. Rola programisty ewoluuje w niesamowitym tempie, a umiejętność tworzenia i integracji inteligentnych systemów staje się jedną z najbardziej pożądanych kompetencji. Co więcej, zarobki w tej branży są rekordowe. Pamiętaj jednak, że pomimo tego ogromnego popytu, wejście dla juniorów jest nadal wyzwaniem i wymaga czegoś więcej niż tylko teorii potrzebujesz solidnego, praktycznego portfolio, które pokaże Twoje realne umiejętności.Redefinicja roli programisty: od kodera do architekta inteligentnych systemów

Jako programista, który od lat obserwuje ewolucję branży, mogę śmiało powiedzieć, że rola developera AI to coś więcej niż tylko pisanie kodu. Dziś stajemy się architektami złożonych systemów, które uczą się, adaptują i podejmują decyzje. Nie chodzi już tylko o implementację algorytmów, ale o projektowanie całych ekosystemów opartych na sztucznej inteligencji, integrowanie ich z istniejącą infrastrukturą i optymalizowanie ich działania. To fascynujące wyzwanie, które wymaga szerokiego spektrum umiejętności.

Rynek pracy w Polsce nie pozostawia złudzeń: gigantyczny popyt i rekordowe zarobki

Dane z ostatnich lat są jednoznaczne. W 2026 roku obserwujemy w Polsce czterokrotny wzrost liczby ofert pracy w kategorii AI/ML w ciągu zaledwie ostatniego roku. To pokazuje, jak szybko rośnie zapotrzebowanie na tych specjalistów. Co więcej, zarobki są naprawdę imponujące doświadczeni eksperci AI mogą liczyć na wynagrodzenia sięgające nawet 40 000 zł miesięcznie przy umowach B2B. Muszę jednak podkreślić, że udział ofert dla juniorów jest wciąż niski, oscylując poniżej 5%. To oznacza, że aby skutecznie wejść na ten rynek, musisz wyróżnić się czymś więcej niż tylko dyplomem praktyczne portfolio jest tu absolutnie kluczowe.

AI to nie przyszłość, to teraźniejszość: jak sztuczna inteligencja zmienia każdą branżę

Sztuczna inteligencja przestała być futurystyczną wizją. To technologia, która już teraz transformuje każdą możliwą branżę od medycyny, przez finanse, logistykę, aż po rozrywkę. Widzę to na co dzień w projektach, w których uczestniczę. AI optymalizuje procesy, personalizuje doświadczenia klientów, wspomaga diagnostykę i automatyzuje rutynowe zadania. Jest to technologia, która nie tylko kształtuje naszą przyszłość, ale przede wszystkim definiuje naszą teraźniejszość, stając się niezbędnym elementem nowoczesnej gospodarki.

Fundamenty, których nie możesz pominąć: niezbędna wiedza przed kodowaniem AI

Wiem, że wiele osób chce od razu przejść do pisania kodu i budowania modeli. Rozumiem to, bo to najbardziej ekscytująca część! Jednak jako Gabriel Błaszczyk, muszę Ci powiedzieć, że bez solidnych podstaw matematycznych Twoje zrozumienie algorytmów AI będzie płytkie, a rozwiązywanie problemów znacznie trudniejsze. Matematyka to język, w którym "rozmawiają" algorytmy. Nie chodzi o to, byś został matematykiem, ale byś potrafił zrozumieć, co dzieje się pod maską gotowych bibliotek. To pozwoli Ci efektywnie debugować, optymalizować i tworzyć innowacyjne rozwiązania.

Czy matematyka jest naprawdę konieczna? Absolutne minimum dla programisty AI

Tak, matematyka jest absolutnie konieczna. Nie ma drogi na skróty, jeśli chcesz być dobrym inżynierem AI, a nie tylko użytkownikiem bibliotek. Kluczowe działy, na których musisz się skupić, to: algebra liniowa, która jest podstawą reprezentacji danych; analiza matematyczna, zwłaszcza rachunek różniczkowy, niezbędny do zrozumienia procesów optymalizacji; statystyka i rachunek prawdopodobieństwa, kluczowe do modelowania niepewności i oceny modeli; oraz teoria optymalizacji, która wyjaśnia, jak algorytmy "uczą się" poprzez minimalizację błędów.

Algebra liniowa w praktyce: dlaczego macierze i wektory to język sztucznej inteligencji?

W świecie AI wszystko jest liczbą. Obrazy to macierze pikseli, tekst to wektory słów, a sieci neuronowe wykonują operacje na macierzach wag. Algebra liniowa dostarcza nam narzędzi do efektywnego manipulowania tymi danymi. Rozumienie wektorów, macierzy, ich mnożenia, transformacji czy rozkładów wartości własnych jest fundamentalne do zrozumienia, jak algorytmy takie jak PCA (Principal Component Analysis) czy sieci neuronowe przetwarzają informacje. Bez tego nie zrozumiesz, dlaczego dany algorytm działa tak, a nie inaczej.Rachunek różniczkowy i optymalizacja: jak "uczą się" algorytmy?

Kiedy mówimy, że model AI się "uczy", w dużej mierze mamy na myśli proces optymalizacji. Model próbuje znaleźć najlepsze parametry, które minimalizują funkcję straty, czyli miarę błędu. I tu wkracza rachunek różniczkowy. Pochodne pozwalają nam określić, w jakim kierunku i o ile powinniśmy zmienić parametry modelu, aby zmniejszyć błąd. Algorytmy takie jak propagacja wsteczna w sieciach neuronowych są w całości oparte na rachunku różniczkowym. Zrozumienie tego mechanizmu jest kluczowe do efektywnego trenowania i dostrajania modeli.

Statystyka i prawdopodobieństwo: jak nauczyć maszynę radzenia sobie z niepewnością?

Świat, w którym działają systemy AI, jest pełen niepewności. Dane są zaszumione, niekompletne, a przyszłe zdarzenia są tylko prawdopodobne. Statystyka i rachunek prawdopodobieństwa dostarczają nam narzędzi do modelowania tej niepewności. Dzięki nim możemy oceniać jakość naszych modeli, rozumieć rozkłady danych, szacować ryzyko i podejmować decyzje w oparciu o prawdopodobieństwo. Koncepcje takie jak rozkład normalny, hipotezy statystyczne czy twierdzenie Bayesa są niezbędne do budowania solidnych i wiarygodnych systemów AI.

Narzędziownia specjalisty AI: wybór języka programowania i bibliotek

Kiedy już zbudujesz solidne fundamenty teoretyczne, nadejdzie czas na praktykę. W tej sekcji przedstawię Ci najważniejsze języki programowania i biblioteki, które stanowią trzon pracy każdego specjalisty AI. Wybór odpowiednich narzędzi jest kluczowy do efektywnego przetwarzania danych, budowania modeli i wdrażania rozwiązań. To właśnie te narzędzia pozwolą Ci przekształcić wiedzę teoretyczną w działające systemy.

Python dlaczego stał się niekwestionowanym królem Machine Learning?

Jeśli miałbym wskazać jeden język programowania, który jest absolutnym fundamentem w AI i Machine Learning, bez wahania powiedziałbym: Python. Jego prostota, czytelność składni i ogromny ekosystem bibliotek sprawiły, że stał się niekwestionowanym liderem. Społeczność Pythona jest gigantyczna, co oznacza mnóstwo zasobów, tutoriali i wsparcia. Oczywiście, istnieją inne języki C++ jest używany tam, gdzie liczy się maksymalna wydajność, Java w korporacyjnych systemach, a Julia zyskuje na popularności w obliczeniach naukowych. Jednak dla większości zastosowań i dla każdego, kto zaczyna, Python to najlepszy wybór. Ja sam opieram na nim większość swojej pracy.

Twój pierwszy zestaw narzędzi: NumPy, Pandas i Matplotlib do oswajania danych

Zanim zaczniesz budować modele, musisz nauczyć się pracować z danymi. I tu wkracza Twój pierwszy, niezbędny zestaw narzędzi:

- NumPy: To biblioteka do numerycznych obliczeń w Pythonie, która jest podstawą dla wielu innych bibliotek AI. Umożliwia efektywne operacje na dużych tablicach i macierzach, co jest kluczowe w algebrze liniowej i przetwarzaniu danych.

- Pandas: Jeśli NumPy to fundament, to Pandas jest narzędziem do budowania na nim. To biblioteka do manipulacji i analizy danych, która wprowadza struktury takie jak DataFrame, znacznie ułatwiające pracę z tabelarycznymi danymi, ich czyszczenie, filtrowanie i agregowanie.

- Matplotlib/Seaborn: Te biblioteki są Twoimi oczami w świecie danych. Pozwalają na tworzenie różnego rodzaju wykresów i wizualizacji, które są niezbędne do eksploracji danych, identyfikacji wzorców i prezentowania wyników. Bez dobrej wizualizacji trudno zrozumieć, co dzieje się w danych.

Scikit-learn: idealny start w świat klasycznego uczenia maszynowego

Kiedy już opanujesz Pythona i narzędzia do analizy danych, czas na Scikit-learn. To standardowa biblioteka do klasycznych algorytmów uczenia maszynowego. Znajdziesz w niej implementacje regresji liniowej, logistycznej, drzew decyzyjnych, maszyn wektorów nośnych (SVM), algorytmów klastrowania (k-means) i wielu innych. Scikit-learn jest niezwykle intuicyjny i posiada spójny interfejs API, co czyni go doskonałym punktem wyjścia dla początkujących. Pozwala szybko budować i testować pierwsze modele predykcyjne, bez zagłębiania się w skomplikowane detale implementacyjne.

Głębokie uczenie w praktyce: starcie gigantów TensorFlow (Keras) vs PyTorch

Gdy klasyczne uczenie maszynowe przestanie Ci wystarczać i zechcesz zanurzyć się w świat sieci neuronowych, staniesz przed wyborem dwóch głównych frameworków: TensorFlow (często używany z Keras jako uproszczonym interfejsem) i PyTorch. TensorFlow, rozwijany przez Google, jest bardzo popularny w środowiskach produkcyjnych, oferując skalowalność i narzędzia do wdrażania modeli. Keras, jako jego wysokopoziomowy interfejs, znacznie ułatwia budowanie sieci neuronowych. PyTorch, rozwijany przez Facebooka, jest z kolei niezwykle popularny w środowiskach badawczych ze względu na swoją elastyczność i "Pythoniczną" naturę, która ułatwia debugowanie i eksperymentowanie. Oba są potężnymi narzędziami, a wybór często zależy od preferencji i specyfiki projektu. Ja osobiście używam obu, w zależności od potrzeb.

Twoja mapa drogowa: jak zostać programistą AI krok po kroku

Zbudowanie kariery w AI to maraton, nie sprint. Wiem, że początek może wydawać się przytłaczający, ale z jasno określoną ścieżką nauki, osiągniesz swój cel. Przygotowałem dla Ciebie ustrukturyzowaną mapę drogową, która przeprowadzi Cię od absolutnych podstaw do zaawansowanych zagadnień. Pamiętaj, że kluczem jest konsekwencja i praktyka. Nie przeskakuj etapów każdy z nich buduje fundament pod kolejny.

Krok 1: Zbuduj solidne fundamenty w Pythonie co konkretnie musisz umieć?

Zanim zaczniesz myśleć o AI, musisz być biegły w Pythonie. Nie wystarczy znać składnię musisz rozumieć, jak efektywnie używać języka do manipulacji danymi. Oto kluczowe koncepcje, które musisz opanować:

-

Podstawy języka: Zmienne, typy danych, operatory, instrukcje warunkowe (

if/else), pętle (for/while). - Struktury danych: Listy, krotki, słowniki, zbiory i co ważniejsze, kiedy której używać.

- Funkcje: Definiowanie funkcji, argumenty, zwracane wartości, funkcje anonimowe (lambda).

- Programowanie obiektowe (OOP): Klasy, obiekty, dziedziczenie, polimorfizm to klucz do zrozumienia wielu bibliotek AI.

- Moduły i pakiety: Jak importować i używać bibliotek, jak organizować swój kod.

- Obsługa plików: Czytanie i zapisywanie danych z różnych formatów (CSV, JSON, tekst).

-

Zarządzanie błędami: Bloki

try-exceptdo obsługi wyjątków. - Rozumienie list comprehensions i generatorów: To bardzo efektywne sposoby pracy z danymi w Pythonie.

Krok 2: Zostań mistrzem analizy danych od czyszczenia danych do wizualizacji

Dane to paliwo dla AI. Bez umiejętności ich analizy i przygotowania, żaden model nie zadziała poprawnie. Ten etap jest często niedoceniany, ale to tutaj spędza się najwięcej czasu w realnych projektach. Oto co musisz umieć:

- Czyszczenie danych: Radzenie sobie z brakującymi wartościami, duplikatami, błędnymi formatami.

- Wstępne przetwarzanie danych (preprocessing): Normalizacja, standaryzacja, kodowanie zmiennych kategorycznych (one-hot encoding), tworzenie nowych cech (feature engineering).

- Eksploracja danych (EDA): Użycie statystyk opisowych (średnia, mediana, odchylenie standardowe) oraz wizualizacji (histogramy, wykresy rozrzutu) do zrozumienia struktury danych i wykrycia anomalii.

- Manipulacja danymi za pomocą NumPy i Pandas: Efektywne filtrowanie, sortowanie, łączenie i agregowanie danych.

- Wizualizacja danych za pomocą Matplotlib i Seaborn: Tworzenie czytelnych i informatywnych wykresów, które pomogą Ci i innym zrozumieć dane i wyniki modeli.

Krok 3: Pierwsze modele predykcyjne z Scikit-learn praktyczne projekty

Kiedy już opanujesz Pythona i analizę danych, czas na budowanie pierwszych modeli. Scikit-learn jest do tego idealny. Skup się na praktycznych projektach, które pozwolą Ci zastosować wiedzę w realnych scenariuszach. Zacznij od prostych zadań, takich jak:

- Klasyfikacja: Przewidywanie, do której kategorii należy dany obiekt (np. czy e-mail to spam, czy nie; czy klient odejdzie, czy zostanie). Wykorzystaj algorytmy takie jak regresja logistyczna, drzewa decyzyjne, lasy losowe.

- Regresja: Przewidywanie wartości liczbowej (np. ceny domu, prognozy sprzedaży). Zacznij od regresji liniowej.

- Klastrowanie: Grupowanie podobnych obiektów bez wcześniejszej wiedzy o kategoriach (np. segmentacja klientów). Algorytm k-means to dobry początek.

Każdy projekt powinien obejmować cały cykl: od wczytania danych, przez ich przygotowanie, trenowanie modelu, aż po jego ocenę. To buduje Twoje doświadczenie.

Krok 4: Zanurz się w świat sieci neuronowych i Deep Learningu

Po opanowaniu klasycznego ML, możesz przejść do głębokiego uczenia. Zacznij od zrozumienia podstawowych koncepcji sieci neuronowych: neuronów, warstw, funkcji aktywacji, propagacji wstecznej. Następnie wybierz jeden z frameworków TensorFlow/Keras lub PyTorch i zacznij budować proste sieci. Na początek spróbuj:

- Klasyfikacji obrazów (np. MNIST, CIFAR-10).

- Prostej sieci neuronowej do regresji.

Głębokie uczenie otwiera drzwi do rozwiązywania bardziej złożonych problemów, zwłaszcza z danymi niestrukturalnymi, takimi jak obrazy, tekst czy dźwięk.

Uczenie maszynowe a głębokie uczenie kluczowe różnice, które musisz zrozumieć

Często widzę, że te dwa terminy są używane zamiennie, co jest błędem. Pozwól, że to wyjaśnię. Uczenie maszynowe (Machine Learning - ML) to szeroka dziedzina sztucznej inteligencji, która zajmuje się tworzeniem algorytmów pozwalających maszynom uczyć się z danych bez jawnego programowania. Obejmuje to zarówno klasyczne algorytmy (regresja, drzewa decyzyjne, SVM), jak i te bardziej zaawansowane. Głębokie uczenie (Deep Learning - DL) jest natomiast poddziedziną ML, która wykorzystuje wielowarstwowe sieci neuronowe (tzw. głębokie sieci) do modelowania złożonych wzorców w danych. DL jest szczególnie skuteczne w pracy z dużymi zbiorami danych niestrukturalnych, takich jak obrazy, tekst, mowa czy wideo, gdzie klasyczne algorytmy ML często sobie nie radzą. Kluczowa różnica polega na architekturze i zdolności do automatycznego uczenia się reprezentacji cech z surowych danych, co w klasycznym ML często wymaga ręcznego inżynierii cech.

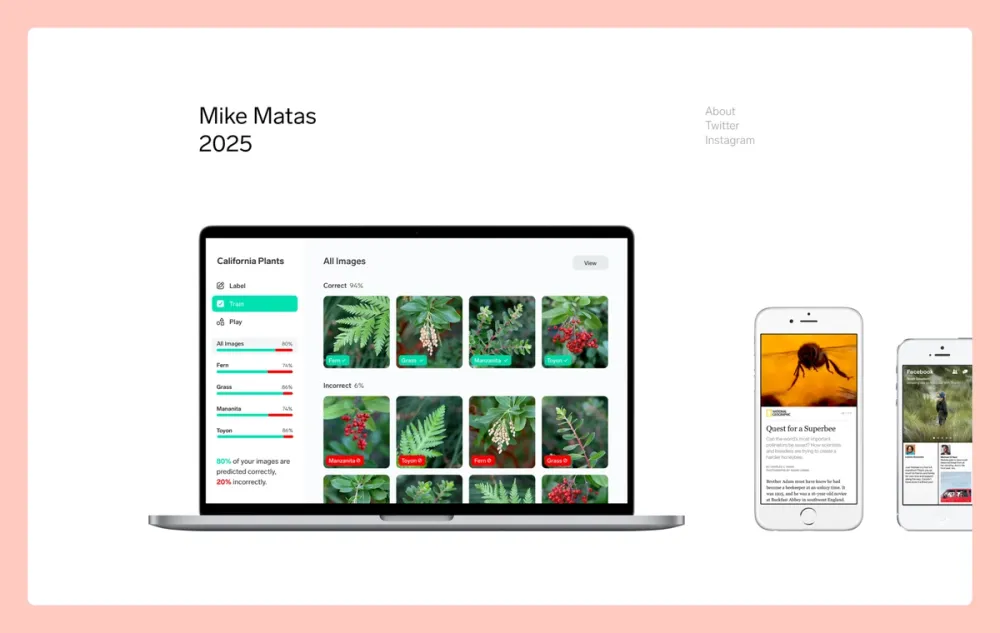

Od teorii do praktyki: zbuduj portfolio, które otworzy Ci drzwi do pracy

Znam to z własnego doświadczenia i z rozmów z rekruterami: na polskim rynku AI, zwłaszcza dla juniorów, praktyczne portfolio jest absolutnie kluczowe. Teoria jest ważna, ale to projekty pokazują, że potrafisz zastosować wiedzę w realnym świecie. Rynek jest konkurencyjny, a pracodawcy szukają dowodów na Twoje umiejętności rozwiązywania problemów, a nie tylko na to, co przeczytałeś w książkach. Potraktuj każdy projekt jako inwestycję w swoją przyszłość.

Dlaczego portfolio jest ważniejsze niż certyfikaty, zwłaszcza na polskim rynku?

Wielokrotnie widziałem, jak kandydaci z imponującymi certyfikatami, ale bez praktycznych projektów, mieli trudności ze znalezieniem pracy. Na polskim rynku, gdzie wejście dla juniorów jest wyzwaniem, pracodawcy cenią sobie przede wszystkim rzeczywiste umiejętności i zdolność do samodzielnego rozwiązywania problemów. Certyfikaty świadczą o wiedzy teoretycznej, ale portfolio pokazuje, że potrafisz tę wiedzę zastosować, radzić sobie z brudnymi danymi, debugować kod i doprowadzać projekty do końca. To jest właśnie to, co wyróżnia Cię spośród innych kandydatów i otwiera drzwi do rozmów kwalifikacyjnych.

Pomysły na pierwsze projekty AI, które zaimponują rekruterom

Nie musisz od razu tworzyć skomplikowanych systemów. Zacznij od prostych, ale dobrze wykonanych projektów, które pokażą Twoje umiejętności. Oto kilka pomysłów, które z pewnością zaimponują rekruterom:

- Analiza sentymentu: Stwórz model, który klasyfikuje recenzje filmów, komentarze na Twitterze lub opinie o produktach jako pozytywne, negatywne lub neutralne.

- Klasyfikacja obrazów: Wykorzystaj gotowe zbiory danych (np. CIFAR-10, Fashion MNIST) do zbudowania modelu rozpoznającego obiekty na zdjęciach.

- Modele predykcyjne na publicznych zbiorach danych: Wybierz zbiór danych z Kaggle (np. przewidywanie cen domów, przeżywalności pasażerów Titanica) i zbuduj model regresji lub klasyfikacji.

- System rekomendacji: Stwórz prosty system rekomendacji filmów lub produktów na podstawie preferencji użytkowników.

- Wykrywanie anomalii: Zbuduj model, który identyfikuje nietypowe transakcje finansowe lub nietypowe zachowania użytkowników.

Pamiętaj, by każdy projekt był dobrze udokumentowany i zawierał jasny opis problemu, użytych danych, metodologii i uzyskanych wyników.

Wykorzystaj Kaggle i inne platformy do budowania realnego doświadczenia

Kaggle to prawdziwa kopalnia wiedzy i doświadczenia. To platforma, na której znajdziesz ogromne zbiory danych, konkursy z realnymi problemami, a także gotowe rozwiązania (kernels), które możesz studiować i na których możesz się uczyć. Udział w konkursach Kaggle, nawet jeśli nie wygrasz, pozwoli Ci pracować z realnymi danymi, uczyć się od najlepszych i budować swoje portfolio. Poza Kaggle, warto eksplorować inne platformy z otwartymi danymi (np. UCI Machine Learning Repository) oraz brać udział w hackathonach. To wszystko buduje Twoje praktyczne doświadczenie.

GitHub jako Twoja wizytówka: jak prezentować kod i projekty?

GitHub to dziś standard w branży IT i Twoja cyfrowa wizytówka. Każdy projekt, który stworzysz, powinien znaleźć się w publicznym repozytorium na GitHubie. Ale to nie wystarczy. Oto kilka porad, jak efektywnie prezentować swoje projekty:

- Czytelne pliki README: Każdy projekt powinien mieć szczegółowy plik README.md, który jasno opisuje problem, dane, użyte metody, wyniki i instrukcje, jak uruchomić Twój kod.

- Dobrze skomentowany kod: Twój kod powinien być czytelny, zwięzły i dobrze skomentowany. Pokaż, że potrafisz pisać czysty kod.

- Historia commitów: Regularne commity z sensownymi wiadomościami pokazują, że potrafisz efektywnie korzystać z kontroli wersji.

- Przykładowe dane i wyniki: Jeśli to możliwe, dołącz małe przykładowe zbiory danych lub zrzuty ekranu z wynikami, aby rekruter mógł szybko zobaczyć, co osiągnął Twój projekt.

Pamiętaj, że GitHub to nie tylko miejsce na kod, ale także na pokazanie Twojego profesjonalizmu i umiejętności współpracy.

Przeczytaj również: Gogle VR: Czy naprawdę psują wzrok? Jak chronić oczy?

Twoja kariera w AI: jak zdobyć pierwszą pracę i rozwijać się w branży

Dotarcie do tego momentu to już ogromny sukces. Masz wiedzę, narzędzia i portfolio. Teraz czas na ostatnie kroki, które pozwolą Ci zdobyć pierwszą pracę w AI i zaplanować dalszy rozwój kariery. Rynek jest dynamiczny, a możliwości jest wiele, ale kluczem jest odpowiednie przygotowanie i strategiczne podejście.

Jak przygotować CV i profil na LinkedIn pod kątem stanowisk AI/ML?

Twoje CV i profil na LinkedIn to Twoje główne narzędzia marketingowe. Muszą być one precyzyjnie dostosowane do stanowisk AI/ML. Oto kilka wskazówek:

- Słowa kluczowe: Upewnij się, że Twoje CV i LinkedIn zawierają kluczowe terminy, takie jak "Machine Learning", "Deep Learning", "Python", "TensorFlow", "PyTorch", "analiza danych", "przetwarzanie języka naturalnego" (NLP), "wizja komputerowa" (CV).

- Sekcja "Umiejętności": Wymień konkretne biblioteki i frameworki, które znasz (NumPy, Pandas, Scikit-learn, Keras).

- Sekcja "Projekty": To najważniejsza część. Opisz swoje projekty z portfolio, podkreślając problem, użyte metody, technologie i osiągnięte wyniki. Koniecznie podaj linki do repozytoriów na GitHubie.

- Doświadczenie: Jeśli masz jakiekolwiek doświadczenie (nawet staże czy projekty akademickie), opisz, jak wykorzystywałeś w nim umiejętności związane z AI/ML.

- Podsumowanie/O mnie: Napisz krótkie, angażujące podsumowanie, które jasno określa Twoje cele zawodowe i pasję do AI.

Rozmowa rekrutacyjna na stanowisko AI: jakich pytań technicznych możesz się spodziewać?

Rozmowy rekrutacyjne na stanowiska AI/ML są zazwyczaj bardzo techniczne. Musisz być gotowy na pytania z różnych obszarów. Mogą dotyczyć podstaw matematyki (algebra liniowa, rachunek różniczkowy, statystyka), Pythona (struktury danych, algorytmy, programowanie obiektowe), algorytmów ML (jak działają, kiedy ich używać, jak oceniać modele) oraz głębokiego uczenia (architektura sieci neuronowych, funkcje aktywacji, propagacja wsteczna). Często pojawiają się też pytania o Twoje projekty z portfolio bądź gotów szczegółowo opowiedzieć o każdym z nich i uzasadnić swoje decyzje. Przygotuj się również na zadania kodowania na żywo, często związane z manipulacją danymi za pomocą Pandas lub implementacją prostych algorytmów.

Ścieżki rozwoju: od inżyniera ML, przez Data Scientist, po badacza AI

Branża AI oferuje różnorodne ścieżki kariery, każda z nich ma swoją specyfikę. Warto poznać te role, aby świadomie kierować swoim rozwojem:

- Inżynier ML (ML Engineer): Skupia się na wdrażaniu modeli AI do środowiska produkcyjnego, optymalizacji wydajności, budowaniu potoków danych i utrzymywaniu infrastruktury. To rola bardziej inżynierska, wymagająca solidnych umiejętności programistycznych i DevOps.

- Data Scientist: To rola łącząca analizę danych, statystykę i uczenie maszynowe. Data Scientist zajmuje się eksploracją danych, budowaniem modeli predykcyjnych, wyciąganiem wniosków i komunikowaniem ich biznesowi. Wymaga silnych umiejętności analitycznych i komunikacyjnych.

- Badacz AI (AI Researcher): Koncentruje się na tworzeniu nowych algorytmów, rozwijaniu teorii i publikowaniu wyników. To rola bardziej akademicka, często wymagająca doktoratu i głębokiego zrozumienia matematyki oraz najnowszych osiągnięć w dziedzinie AI.

Wybór ścieżki zależy od Twoich zainteresowań i mocnych stron. Pamiętaj, że w dynamicznej branży AI, te role często się przenikają, a elastyczność i ciągła nauka są kluczem do sukcesu.